Неправильний Зеленський і сумнівний Трамп: що в цих відео видає діпфейк

Deepfake - це методика створення та публікації хибної інформації у вигляді відео, аудіо та фотографій

Діпфейк - це метод створення фотографій та відеороликів за допомогою алгоритмів глибокого навчання. Технологія дозволяє в існуючих медіаданих замінювати обличчя людини зовсім інше. Але завдяки цьому інформаційні маніпуляції вийшли на новий рівень. Тому експерти радять звертати увагу на зайві пальці, порівнювати манери з реальними записами та застосовувати здоровий глузд і скептицизм.

Існує велике занепокоєння щодо дипфейків, зображень чи аудіозаписів провідних політичних діячів, створених за допомогою штучного інтелекту та призначених для введення виборців в оману, а також щодо того, чи вплинуть вони на результати, пише The Guardian. Є постійний потік прикладів у всьому світі, у тому числі в Україні. Ось візуальні елементи, куди слід звернути увагу.

Дива навколо рота або підборіддя

У відео з дипфейком область навколо рота може бути найбільшою ознакою. Може бути менше зморшок на шкірі, менше деталей навколо рота, або підборіддя виглядає розмитим або змащеним. Погана синхронізація між голосом та ротом людини може бути ще однією ознакою.

Це відео deepfake, опубліковане 17 червня, демонструє симуляцію руйнування будинку Ріші Сунака у Minecraft Найджелом Фараджем. Це частина тенденції відео deepfake сатири, в яких політики грають в онлайн-гру.

"Першою ознакою фейків Minecraft є, звичайно ж, "безглуздість ситуації". Але ще однією ознакою медіа чи маніпуляції, створених ШІ, є недосконала синхронізація голосу та рота. Це особливо помітно у фрагменті, де говорить Фарадж", - розповів доктор Мхайрі Ейткен, науковий співробітник з етики в Інституті Алана Т'юрінга, національному інституті Великобританії з ШІ.

За словами Ейткена, ще однією ознакою є те, чи падають тіні в потрібному місці, чи зміщуються лінії та зморшки на обличчі, коли ви очікуєте їх зміщення. Арді Джанджева, науковий співробітник інституту, додає, що низький дозвіл на протязі всього відео - ще одна очевидна ознака, яку люди повинні помітити, бо це "одразу нагадує щось склеєне". Він каже, що люди знайомі з цим аматорським підходом через поширеність "елементарних спроб шахрайства з низьким дозволом". Цей низькоякісний підхід потім виявляється у очевидних областях, таких як рот і лінія підборіддя.

"Це видно по рисах обличчя, таким як рот, на якому глядачі схильні фокусувати свою увагу, де спостерігається надмірне розмиття та змащування", - сказав Арді.

Дивні елементи мови

Ще одне фейкове відео було зроблено з Кейром Стармером, який продає інвестиційну схему шляхом монтажу звуку в його новорічному обігу 2023 року. Якщо ви уважно послухаєте, то зауважте, що структура пропозиції дивна: Стармер кілька разів вимовляє слово "фунтів" перед числом, наприклад, "35 000 фунтів на місяць".

Знову ж таки голос і рот не синхронізовані, а нижня частина обличчя розмита. Використання "фунтів" перед числом вказує на те, що для відтворення голосу Стармера, ймовірно, використовувався інструмент перетворення тексту в аудіо.

"Це, ймовірно, вказує на те, що для перетворення письмових слів на мову використовувався інструмент, без перевірки того, чи це відображає типові зразки розмовної мови", - додав Мхайрі.

Також є деякі підказки в інтонації: це зберігає досить монотонний ритм та зразок протягом усього відео. Щоб перевірити достовірність відео, гарною ідеєю буде порівняти голос, манери та вирази з реальними записами людини, щоб побачити, чи вони відповідають один одному.

Узгодженість між обличчям та тілом

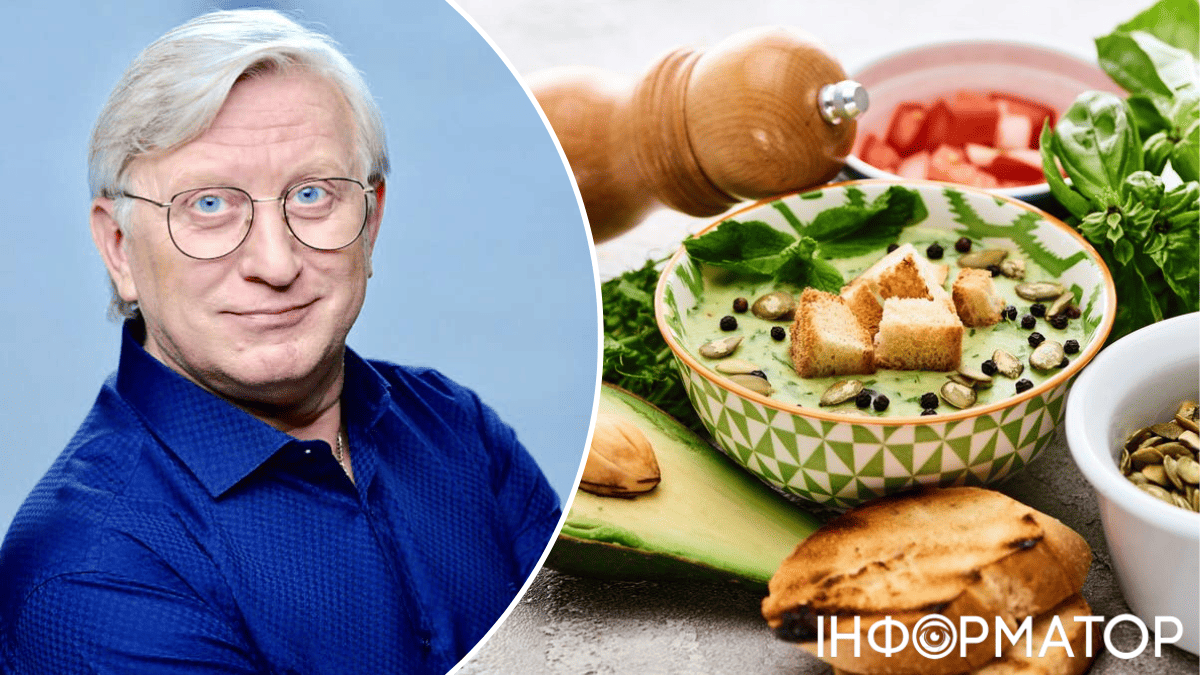

А це фейкове відео президента України Володимира Зеленського, яке закликає мирних жителів скласти зброю перед російськими військовими, було поширене у березні 2022 року. Ми моемо побачити, що голова непропорційна решті тіла, а відтінки шкіри на шиї та обличчі різняться.

"Це дипфейк старої школи. Нерухливе тіло видає. Вірна ознака цього так званого дипфейка ляльковода - те, що тіло нижче шиї не рухається", - пояснив Хані Фарід, професор Каліфорнійського університету в Берклі та спеціаліст з виявлення дипфейків.

Розрив у відеокліпі

Це відео, поширене у травні 2024 року, помилково показує, як представник Держдепартаменту США Метью Міллер виправдовує українські військові удари по російському місту Бєлгород, говорячи репортеру, що "у Бєлгороді практично не залишилося мирних жителів". Відео було опубліковано в Twitter посольством Росії у Південній Африці, а потім видалено. На фейковому відео видно, як краватка та сорочка представника змінюють колір в одному місці відео.

Хоча це досить помітна зміна, Фарід зазначає, що ландшафт генеративного ШІ швидко змінюється, а значить, і вказівники на дипфейк.

"Ми також повинні завжди практикувати гарні звички споживання інформації, які включають поєднання старого доброго здорового глузду та здорової частки скептицизму, коли нам висувають особливо обурливі чи малоймовірні заяви", - додав він.

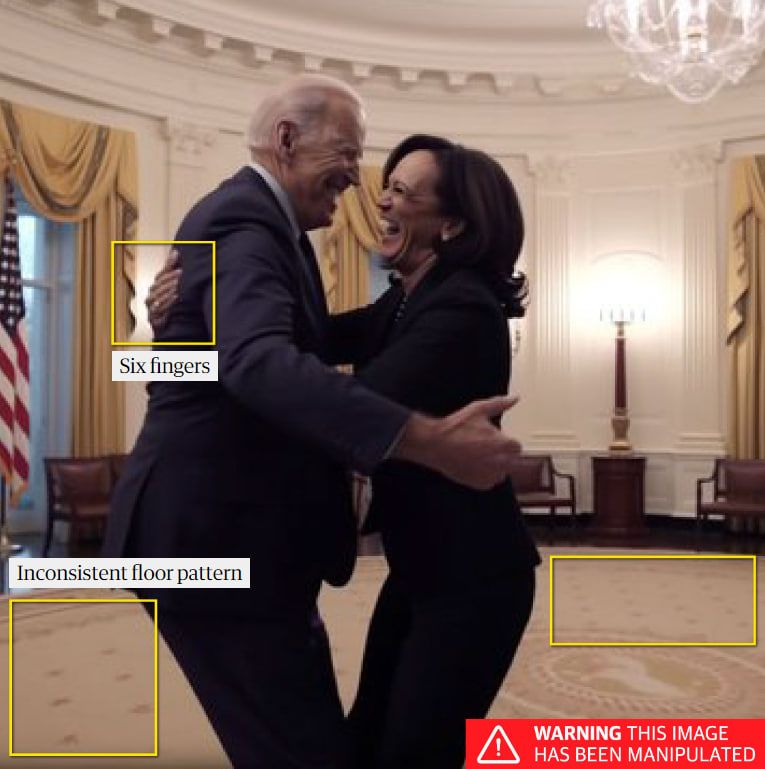

Додаткові пальці, руки, кінцівки

Зверніть увагу на надлишок пальців, ніг, рук і кистей, що дивно виглядають, на нерухомих зображеннях, створених за допомогою штучного інтелекту. Так, у квітні 2023 року в Twitter була поширена фотографія, на якій нібито зображені президент США Джо Байден і віце-президент Камала Харріс, які святкують звинувачувальний висновок Дональду Трампу.

Ознаки того, що це могло бути згенероване ШІ, включають праву руку Камали Харріс із шістьма пальцями. Верхня частина прапора перекручена, малюнок на підлозі також спотворений. Команда ШІ в Reality Defender, фірмі з виявлення дипфейків, стверджує, що підказки, що вводяться в інструменти генерації зображень, можуть фокусуватися на людях - це часто імена відомих людей, - що призводить до вихідних даних, що підкреслюють особи. В результаті підробка часто розкривається в інших деталях, таких як руки або фізичне тло, як у випадку із зображенням Байдена-Харріса.

Проте компанія Reality Defender, яка використовує інструменти виявлення дипфейків, стверджує, що складність програм генеративного ШІ, що зростає, означає, що ручна перевірка дипфейків стає "явно менш надійною".

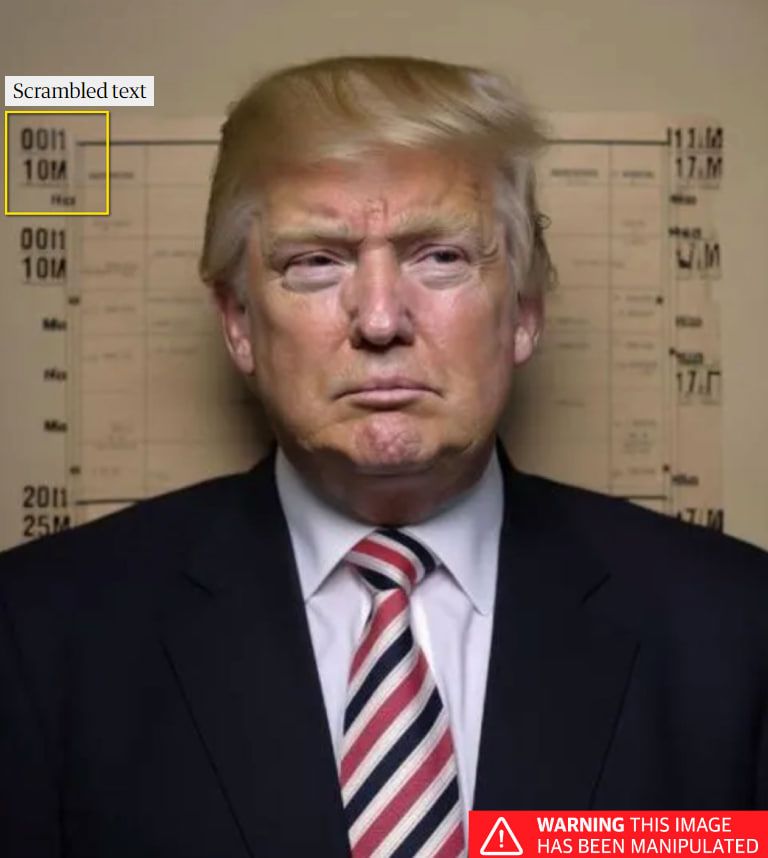

Спотворені літери та цифри

Генератори зображень на основі ШІ мають труднощі з відтворенням цифр і тексту. Цей фальшивий знімок Трампа, опублікований у квітні 2023 року, було зроблено за допомогою такого інструменту.

"Цифри та текст на задньому плані видають себе", - говорить Ейткен. "Генераторам зображень на основі ШІ справді важко створювати текст чи цифри. Вони не розуміють значення символів, які вони створюють, тому зазвичай видають спотворений чи нерозбірливий текст та цифри. Якщо на зображенні є текст або цифри, їх збільшення може бути справді хорошим способом визначити, чи воно згенероване за допомогою ШІ".

Уривчасті відеомонтажі

Деякі оброблені зображення зібрані настільки непрофесійно, що їх легко помітити. Відомі як "дешеві підробки", часто використовують просте програмне забезпечення для редагування відео та інші низькоякісні методи.

Незадовго до виборів у Мексиці відеозапис тодішнього кандидата в президенти Клаудії Шейнбаум був змонтований так, щоб показати, що він каже, що закриє церкви у разі обрання. Кліп був навмисно склеєний таким образом, що вводить в оману з відео, де вона насправді заявляла: "Вони кажуть, уявіть собі брехню, що ми збираємося закрити церкви". Альтернативний фон із сатанинськими символами також був доданий у спробі зробити кліп ще більш руйнівним.

Підписуйтесь на наш Telegram-канал, щоб не пропустити важливих новин. Підписатися на канал у Viber можна тут.