Неправильный Зеленский и сомнительный Трамп: что в этих видео выдает дипфейк

Deepfake - это методика создания и публикации ложной информации в виде видео, аудио и фотографий

Дипфейк - это метод создания фотографий и видеороликов с помощью алгоритмов глубокого обучения. Технология позволяет у существующих медиаданных заменять лицо человека совсем другое. Но благодаря этому информационные манипуляции вышли новый уровень. Поэтому эксперты советуют обращать внимание на лишние пальцы, сравнивать манеры с реальными записями и применять здравый смысл и скептицизм.

Существует большое беспокойство по поводу дипфейков, изображений или аудиозаписей ведущих политических деятелей, созданных с помощью искусственного интеллекта и предназначенных для введения избирателей в заблуждение, а также того, повлияют ли они на результаты, пишет The Guardian. Есть постоянный поток примеров по всему миру, в том числе в Украине. Вот визуальные элементы, на которые следует обратить внимание.

Странности вокруг рта или подбородка

У видео с дипфейком область вокруг рта может быть наибольшим признаком. Может быть меньше морщин на коже, меньше деталей вокруг рта, или подбородок выглядит размытым или смазанным. Плохая синхронизация между голосом и ртом человека может быть еще одним признаком.

Это видео deepfake, опубликованное 17 июня, демонстрирует симуляцию разрушения дома Риши Сунака в Minecraft Найджелом Фараджем. Это часть тенденции видео deepfake сатиры, где политики играют в онлайн-игру.

"Первым признаком фейков Minecraft является, конечно же, "бессмысленность ситуации". Но еще одним признаком медиа или манипуляции, созданных ИИ, является несовершенная синхронизация голоса и рта. Это особенно заметно во фрагменте, где говорит Фарадж", - рассказал доктор Мхайри Эйткен, научный сотрудник по этике в Институте Алана Тьюринга, национальном институте Великобритании по ИИ.

По словам Эйткена, еще одним признаком является то, падают ли тени в нужном месте, смещаются ли линии и морщины на лице, когда вы ожидаете их смещения. Арди Джанджева, научный сотрудник института, добавляет, что низкое разрешение на протяжении всего видео - еще один очевидный признак, который люди должны заметить, потому что это "сразу напоминает что-то склеенное". Он говорит, что люди знакомы с этим любительским подходом из-за распространенности "элементарных попыток мошенничества с низким разрешением". Этот низкокачественный подход выявляется затем в очевидных областях, таких как рот и линия подбородка.

"Это видно по чертам лица, таким как рот, на котором зрители склонны фокусировать свое внимание, где наблюдается чрезмерное размытие и смазывание", - сказал Арди.

Странные элементы языка

Еще одно фейковое видео было сделано с Кейром Стармером, продающим инвестиционную схему путем монтажа звука в его новогоднем обращении 2023 года. Если вы внимательно послушаете, то заметьте, что структура предложения удивительна: Стармер несколько раз произносит слово "фунтов" перед числом, например "35 000 фунтов в месяц".

Опять же голос и рот не синхронизированы, а нижняя часть лица размыта. Использование "фунтов" перед числом указывает на то, что для воспроизведения голоса Стармера, вероятно, использовался инструмент преобразования текста в аудио.

"Это, вероятно, указывает на то, что для превращения письменных слов в язык использовался инструмент, без проверки того, отражает ли это типичные образцы разговорного языка", - добавил Мхайри.

Также есть некоторые подсказки в интонации: это сохраняет монотонный ритм и образец на протяжении всего видео. Чтобы проверить достоверность видео, хорошей идеей будет сравнить голос, манеры и выражения с реальными записями человека, чтобы увидеть, отвечают ли они друг другу.

Согласованность между лицом и телом

А это фейковое видео президента Украины Владимира Зеленского, призывающее мирных жителей сложить оружие перед российскими военными, было распространено в марте 2022 года. Мы видим, что голова непропорциональна остальному телу, а оттенки кожи на шее и лице различаются.

"Это дипфейк старой школы. Неподвижное тело выдает. Верный признак этого так называемого дипфейка кукловода - то, что тело ниже шеи не двигается", - пояснил Хани Фарид, профессор Калифорнийского университета в Беркли и специалист по выявлению дипфейков.

Разрыв в видеоклипе

Это видео, распространенное в мае 2024 года, ошибочно показывает, как представитель Госдепартамента США Мэтью Миллер оправдывает украинские военные удары по российскому городу Белгород, говоря репортеру, что "в Белгороде практически не осталось мирных жителей". Видео было опубликовано в Twitter посольством России в Южной Африке и затем удалено. На фейковом видео видно, как галстук и рубашка представителя меняют цвет в одном месте видео.

Хотя это довольно заметное изменение, Фарид отмечает, что ландшафт генеративного ИИ быстро меняется, а значит и указатели на дипфейк.

"Мы также должны всегда практиковать хорошие привычки потребления информации, включающие сочетание старого доброго здравого смысла и здоровой доли скептицизма, когда нам выдвигают особо возмутительные или маловероятные заявления", - добавил он.

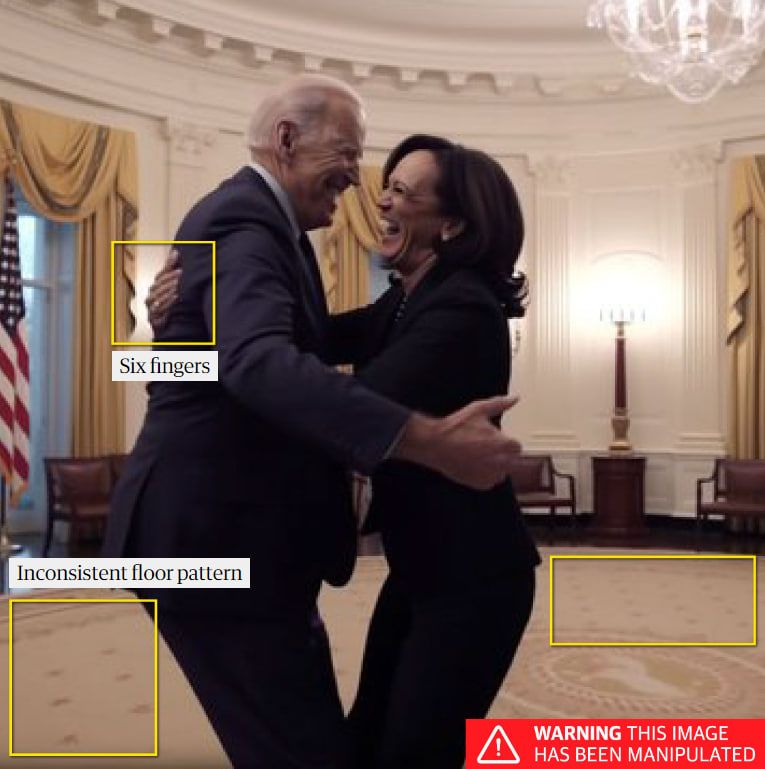

Дополнительные пальцы, руки, конечности

Обратите внимание на излишек пальцев, ног, рук и удивительно выглядящих кистей на неподвижных изображениях, созданных с помощью искусственного интеллекта. Так, в апреле 2023 года в Twitter была распространена фотография, на которой якобы изображены президент США Джо Байден и вице-президент Камала Харрис, празднующие обвинительное заключение Дональда Трампа.

Признаки того, что это могло быть сгенерировано ИИ, включают правую руку Камалы Харрис с шестью пальцами. Верхняя часть флага извращена, рисунок на полу также искажен. Команда ИИ в Reality Defender, фирме по обнаружению дипфейков, утверждает, что вводимые в инструменты генерации изображений подсказки могут фокусироваться на людях - это часто имена известных людей, - что приводит к исходным данным, подчеркивающим личности. В результате подделка часто раскрывается в других деталях, таких как руки или физический фон, как в случае с изображением Байдена-Харриса.

Однако компания Reality Defender, использующая инструменты обнаружения дипфейков, утверждает, что растущая сложность программ генеративного ИИ означает, что ручная проверка дипфейков становится "явно менее надежной".

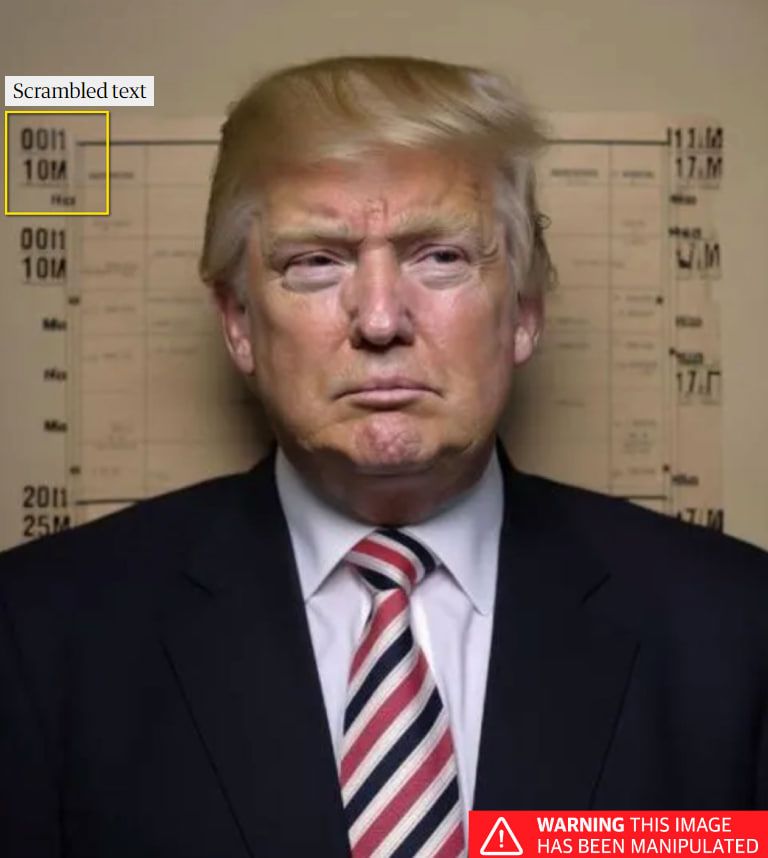

Искаженные буквы и цифры

Генераторы изображений на основе ИИ испытывают трудности с воспроизведением цифр и текста. Этот фальшивый снимок Трампа, опубликованный в апреле 2023 года, был сделан с помощью такого инструмента.

"Цифры и текст на заднем плане выдают себя", - говорит Эйткен. "Генераторам изображений на основе ИИ действительно трудно создавать текст или цифры. Они не понимают значения символов, которые они создают, поэтому обычно издают искаженный или неразборчивый текст и цифры. Если на изображении есть текст или цифры, их увеличение может быть действительно хорошим способом определить, или оно сгенерировано с помощью ИИ".

Отрывистые видеомонтажи

Некоторые обработанные изображения собраны настолько непрофессионально, что их легко заметить. Известные как "дешевые подделки" часто используют простое программное обеспечение для редактирования видео и другие низкокачественные методы.

Незадолго до выборов в Мексике видеозапись тогдашнего кандидата в президенты Клаудии Шейнбаум была смонтирована так, чтобы показать, что он говорит, что закроет церкви в случае избрания. Клип был намеренно склеен таким образом, что вводит в заблуждение с видео, где она действительно заявляла: "Они говорят, представьте себе ложь, что мы собираемся закрыть церкви". Альтернативный фон с сатанинскими символами был добавлен в попытке сделать клип еще более разрушительным.

Подписывайтесь на наш Telegram-канал, чтобы не пропустить важные новости. Подписаться на канал в Viber можно здесь.