Художники "ослепляют" ИИ котами, чтобы защитить свои работы от кражи

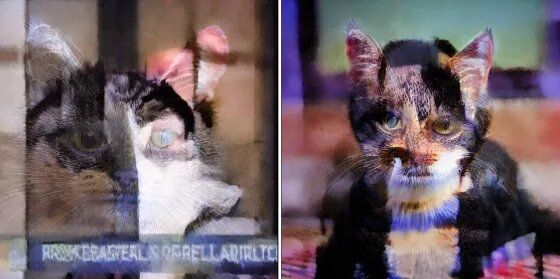

Инструмент Nightshade изменяет изображение незначительными способами

Художники и компьютерные ученые тестируют новый способ, как предотвратить кражу авторских прав искусственным интеллектом. Они ослепляют модели ИИ изображением кошек. Их накладывают на оригинальные изображения так, чтобы это не было заметно человеческому глазу.

Как пишет NBCnews, инструмент под названием Nightshade, выпущенный в январе исследователями Чикагского университета, изменяет изображение незначительным образом, что почти незаметно для человеческого глаза, но кардинально отличается для платформ ИИ, обрабатывающих фото. Теперь художники, такие как Карла Ортис используют Nightshade для защиты своих произведений от сканирования и копирования программами для преобразования текста в изображения, такими как DreamUp от DeviantArt, Stable Diffusion от Stability AI и другими.

“Меня поразило то, что значительная их часть – это, по сути, вся моя работа, вся работа моих коллег, почти все работы художников, которых я знаю. И все это было сделано без чьего-либо согласия – без признания, без компенсации, без вообще ничего”, – сказала Ортис, концепт-художница и иллюстратор, чье портфолио позволило ей получить работу по разработке визуальных эффектов для фильмов, телевидения и видеоигр, таких как “ Звездные войны”, “Черная пантера” и Final Fantasy XVI.

Nightshade использует тот факт, что модели ИИ видят мир не так, как люди, – отметил руководитель исследований Шон Шен.

“Машины, они видят только большой массив чисел, верно? Это значение пикселей от нуля до 255 и для модели это все, что она воспринимает. Таким образом, Nightshade сменяет тысячи пикселей – это капля в море для стандартных изображений, содержащих миллионы пикселей, но достаточная, чтобы обмануть модель и заставить ее увидеть что-то совсем другое", – пояснил Шен, аспирант в Чикагском университете.

В статье, которая будет представлена в мае, команда описывает, как Nightshade автоматически выбирает concept, которым она намерена запутать программу ИИ, реагирующую на определенный запрос – например, встраивая искажения пикселей в фотографии “собак”, воспринимаемые моделью как “кошка” . После того, как 1000 едва заметно отравленных фотографий собак подали на вход текстово-графическому инструменту ИИ и запросили изображение собаки, модель генерирует что-то совершенно не похожее на собаку.

Хотя искажения Nightshade не всегда превращаются в кошачьи, программа решает в каждом конкретном случае, какое альтернативное понятие она хочет, чтобы его "увидел" ИИ. По словам Шена, в некоторых случаях нужно только 30 "ослепленных" фотографий, чтобы таким образом отравить модель.

Бен Жао, профессор компьютерных наук, возглавляющий разработавшую Nightshade лабораторию Чикагского университета, не ожидает массового принятия этого инструмента на уровне, который мог бы угрожать уничтожением генераторов изображений на основе ИИ. Зато он описал его как "копье", которое может сделать некоторые более узкие применения настолько непригодными, что заставит компании платить, когда они копируют работы художников.

"Если вы являетесь создателем любого типа, например, делаете фотографии, и вы не обязательно хотите, чтобы ваши фотографии использовались для обучения модели – или чтобы сходство ваших детей или ваше собственное сходство попадали в модель – тогда Nightshade – это то, что вы можете рассмотреть», – сказал Жао.

Инструмент бесплатный для использования. Жао сказал, что намерен оставить его таким.

Модели, такие как Stable Diffusion, уже предлагают возможность "отказаться", чтобы художники могли предупредить не использовать их контент, а представитель Stability AI отметил, что они были одной из первых компаний, принявших участие в реестре "не учить". Но многие владельцы авторских прав жалуются, что распространение инструментов ИИ опережает их усилия по защите своей работы.

Дискуссия по защите интеллектуальной собственности дополняет более широкий спектр этических проблем в отношении ИИ, включая распространенность дипфейков и вопрос о границах использования водяных знаков для сдерживания этих и других злоупотреблений. Хотя в области ИИ растет признание того, что нужны дополнительные меры предосторожности, быстрое развитие технологий – включая более новые инструменты для преобразования текста в видео, такие как Sora от OpenAI – беспокоит некоторых экспертов.

"Я не знаю, много ли это даст, потому что будет технологическое решение, которое станет контрмерой к такой атаке", - сказала о Nightshade Соня Шмер-Галундер, профессор ШИ и этики в Университете Флориды.

Ученые Чикагского университета признают вероятность появления "потенциальных защитных механизмов" против ослепления изображений Nightshade, поскольку платформы ИИ обновляются, чтобы отфильтровывать данные и изображения, подозреваемые в прохождении "ненормальных изменений".

Жао считает несправедливым возлагать груз на отдельных лиц, чтобы отгонять модели ИИ от своих изображений.

"К скольким компаниям вам нужно обращаться лично, чтобы сказать им не нарушать ваши права?" – сказал он.

Между тем Ортис считает Nightshade полезной "атакой", которая предоставляет ее работе определенной защиты, пока она ищет более действенных методов в суде.

"Nightshade просто говорит: "Эй, если вы возьмете это без моего согласия, могут быть последствия", – сказала Ортис, входящая в состав коллективного иска, поданного против Stability AI, Midjourney и DeviantArt в январе 2023 года о нарушении авторских прав.

Суд в конце прошлого года отклонил некоторые аргументы истцов, но оставил им возможность подать исправленное исковое заявление, что они сделали в ноябре, добавив в качестве ответчика Runway AI. В ходатайстве об отклонении иска в начале этого года Stability AI утверждала, что "простое подражание художественному стилю не является нарушением авторских прав на любую работу". Stability AI отказалась комментировать судебный процесс. Midjourney, DeviantArt и Runway AI не ответили на запросы комментариев.

Оксфордский университет разработал ИИ-помощника для врачей: DrugGPT

Ученые Оксфордского университета представили инновационный инструмент под названием DrugGPT, который призван помочь врачам избежать ошибок при назначении лекарства. Этот ИИ-помощник, разработанный в качестве "помощника врача", будет предоставлять медикам альтернативные варианты лечения на основе введенной информации о состоянии пациента.

DrugGPT работает с помощью чат-бота, куда врач вводит данные о пациенте. На основе этих данных ИИ анализирует доступные варианты лечения и предлагает оптимальные рекомендации. Эти рекомендации могут включать в себя исследования, блок-схемы и ссылки на дополнительные ресурсы.

Напомним, ранее Информатор писал, что ChatGPT можно использовать без регистрации. Пока эта услуга доступна не во всех странах. Однако украинские пользователи уже могут попробовать.

Подписывайтесь на наш Telegram-канал, чтобы не пропустить важные новости. Подписаться на канал в Viber можно здесь.